La maladie à coronavirus COVID-19, apparue en décembre 2019 à Wuhan en Chine sur un marché de la ville, a surpris les autorités chinoises par la rapidité de sa propagation. Elle a très vite touché des centaines d’habitants. Malgré la quarantaine qui a confiné 11 millions de Chinois chez eux fin janvier, la contagion a gagné plusieurs autres villes et d’autres foyers se sont fait jour non seulement en Chine mais au Japon, en Corée du Sud, en Iran, et tout récemment en Italie du Nord. Fin février, ce sont plus de 82 000 malades atteints et 2800 décès dans le monde, et outre les villes de la province de Hubei dont Wuhan est la capitale, plusieurs villes d’Italie sont fermées. Le patron de l’OMS s’inquiète d’une pandémie qui pourrait s’étendre mondialement, et la France, comme d’autres pays, s’y prépare.

Qu’est-ce qu’un virus ?

Plus petit que 100 nanomètres un virus ne peut pas être considéré comme un organisme vivant car il ne peut pas se répliquer seul. Il est constitué d’un assemblage de molécules, pour l’essentiel des ADN ou ARN et des protéines. Lors du contact avec un organisme vivant (homme, animal, plante…) le virus va utiliser la machinerie moléculaire de cet organisme vivant pour se répliquer et se démultiplier en plusieurs copies qui vont coloniser plusieurs centres vitaux de son hôte : voies respiratoires, intestins, sang…

Comment le virus nous attaque ?

Les coronavirus sont presque toujours d’origine animale, l’habitude chinoise d’acheter sur les marchés de petits animaux vivants comme les poissons, les volailles, les petits mammifères, confinés dans un espace restreint, ont sûrement développé une énorme charge virale. De plus la concentration des habitants en mégapoles de plusieurs millions d’habitants a probablement favorisé la propagation du virus. Il faut y ajouter le fort développement de la Chine depuis plusieurs années qui entraîne des migrations humaines nationales et internationales dans tous les secteurs : commercial, technique et scientifique.

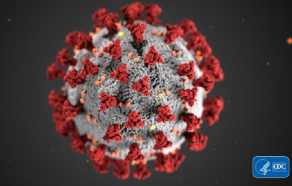

Les coronavirus doivent leur nom à une petite couronne de protéines pointues dites spicules. Il y a deux sortes de coronavirus : ceux peu pathogènes qui circulent en France chaque année par temps froid et humide en hiver et disparaissent en été, provoquant les rhumes, laryngites et grippes saisonnières et ceux au comportement hautement pathogène dont deux sont déjà connus le SARS-CoV en 2003 responsable du SRAS (Syndrome Respiratoire Aigu Sévère) et le MERS-CoV responsable du MERS (Middle East respiratory syndrome) en 2012, qui ont fait des victimes en Chine et au Moyen-Orient. Ce nouveau virus, temporairement appelé en janvier 2019–nCoV et définitivement nommé SARS-CoV-2 le 11 février 2020 par l’ICTV (Comité international de taxonomie des virus), était inconnu jusqu’à ce que plusieurs laboratoires dans le monde dont celui de l’Institut Pasteur en France l’isolent, grâce aux prélèvements positifs. Le laboratoire parisien commence à le cultiver sur des souches pathogènes dès le 24 janvier 2020. La collaboration internationale a alors permis très rapidement le séquençage complet du génome de ce coronavirus et ainsi de commencer à étudier sa structure pour comprendre la façon dont il nous attaque (1).

Le virus transmis par des postillons ou des aérosols émis par les malades pénètre dans les cellules nasales. Grâce à cette couronne de protéines pointues (spicules) il se verrouille sur une protéine de surface des cellules appelée récepteur. On peut aussi assimiler les spicules à une « clé » qui se fixe sur la « serrure » du récepteur (2). Le virus libère alors via une vésicule dite endosome son ARN (3) dans le cytoplasme de la cellule qui produit alors les protéines virales nécessaires à sa réplication. Avec son enzyme viral il fait alors de multiples copies de son ARN et donne naissance à plusieurs virus répliqués qui s’échappent de la cellule pour attaquer d’autres cellules et ceci en quelques heures.

Comment réagir et se protéger ?

Grâce à la rapidité du séquençage de son génome, on a pu remonter à la structure du coronavirus. Il y a une semaine une équipe de chercheurs de l’université d’Austin (Texas, USA) a pu mettre au point sa structure 3D et de la partie des spicules (la clé) en utilisant la cryomicroscopie électronique moyen d’étude dont les inventeurs avaient obtenu le prix Nobel de chimie 2017 (4). On peut par ce moyen obtenir de multitudes d’images des molécules figées à basse température et même en faire de petits films. Cette étude a montré de plus que la porte d’entrée dans les cellules humaines était bien le récepteur ACE2 déjà identifié lors du SRAS, mais la « clé » était ici semble-t-il encore mieux adaptée à sa serrure, ce qui pourrait expliquer la rapidité de sa propagation.

Les pistes pour traiter les malades sont alors de deux types :

- des antiviraux qui empêchent la réplication du virus à l’intérieur des cellules comme la chloroquine, une molécule utilisée comme antipaludique et qui bloque la capacité du virus à acidifier les endosomes pour libérer l’ARN, ou le remdesivir qui agit comme un nucléotide sur l’élément constitutif de l’ARN, en s’immisçant dans la séquence copiée, créant une « faute de frappe » et la rendant inutilisable pour la réplication (5).

- des inhibiteurs de protéase déjà testés pour le traitement du VIH, du SRAS et du MERS. Ils bloquent la capacité de la protéine « protease » à couper une longue protéine non fonctionnelle en protéines plus petites nécessaires à la réplication du virus.

L’immunologie par biosynthèse consiste à produire des anticorps dans la cellule en y transférant deux ADN, ces deux ADN seront transcrits en ARN messagers qui vont migrer dans le cytosol et s’ajouteront à la protéine de surface empêchant le virus de se fixer sur sa cible (si la serrure change la clé ne marche plus) (6). C’est aussi une piste pour la vaccination, comme celle d’injecter des anticorps venus de malades guéris. Pour l’instant, les traitements des malades utilisent des molécules comme la chloroquine, le remdesivir ou des inhibiteurs tels que le lopinavir ou le ritonavir et l’interféron déjà connus et utilisés dans les cas de syndromes respiratoires aigus et donnant de bons résultats comme à Bordeaux sur le malade qui est sorti récemment de clinique. Pour un éventuel vaccin il faudra sans doute attendre plusieurs années malgré le nombre de laboratoires de recherche en biochimie et pharmacie qui se sont mis sur le sujet.

En France un plan de veille et de prévention est mis en place en mobilisant plus de 100 hôpitaux et en passant les laboratoires d’analyses à une capacité de plusieurs milliers de tests de dépistage par jour. Une bonne règle personnelle d’hygiène est de se laver les mains régulièrement et de protéger la bouche en cas de toux, cela vous évitera sans doute déjà le rhume ou la grippe de saison (7).

Jean-Claude Bernier, Constantin Agouridas et Catherine Vialle

27 février 2020

Pour en savoir plus

(1) Chimie du et pour le vivant : objectif santé

(2) La chimie supramoléculaire et ses formes modernes

(3) Cibler l’ADN : pour la compréhension du vivant

(4) Le prix Nobel 2017

(5) Molécules hybrides pour de nouveaux médicaments : mythe ou réalité ?

(6) De la biologie de synthèse aux biomédicaments

(7) La chimie et les produits d’hygiène et de soins corporels (Chimie et… Junior)

L'image d'illustration, réalisée par Centers for Disease Control and Prevention (CDC), révèle la morphologie des coronavirus.

Les 28 et 29 février 2020 se tient, au parc floral de Paris au bois de Vincennes, le

Village de la chimie des sciences de la nature et de la vie

Les collégiens, lycéens et étudiants avec leurs professeurs ou leurs parents sont comme chaque année les bienvenus, et nombreux sont ceux qui grâce aux différents espaces et stands vont pouvoir trouver une orientation scolaire, un parcours professionnel, un stage en entreprise, un futur job.

Comment rendre efficace votre venue ?

- 1 – En rencontrant les professionnels à votre disposition : ingénieurs, recruteurs, techniciens de grandes entreprises internationales, de PME, de start–up, d’organismes de recherche ; ils vous parleront métiers et carrières.

- 2 – En vous renseignant auprès des établissements de formation et des filières : Bac Pro, BTS, DUT, Universités, Écoles d’ingénieurs, qui vous accueilleront au cours de ces deux journées.

- 3 – En préparant votre future insertion professionnelle grâce aux ateliers pour peaufiner votre CV, utiliser mieux internet, bâtir ou améliorer votre entretien d’embauche,

Vous aurez aussi la possibilité d’écouter et de vous instruire, au cours des conférences d’experts ou de chercheurs en chimie, sur le traitement des surfaces, l’innovation dans les verres, une méthode révolutionnaire de dépollution des sols.

Ne loupez pas les démonstrations spectaculaires de réactions chimiques et une découverte amusante des éléments de la classification périodique.

Enfin Jean Marie Lehn prix Nobel de chimie sera présent à l’occasion de la remise des prix des Olympiades de la chimie en Île-de-France et parlera de « la chimie de la vie ».

Venez en famille ou avec vos professeurs à Vincennes. L’industrie chimique emploie 165 000 salariés, et il y a de très nombreux chimistes dans d’autres industries comme la pharmacie, la métallurgie, l’automobile, l’aéronautique, la plasturgie, les cosmétiques et parfums. Cela représente chaque année des dizaines de milliers d’embauches. De plus, avec le développement de l’alternance et de l’apprentissage, de nombreuses possibilités sont offertes : venez à la table ronde spécialement consacrée à ces voies le samedi 29.

Préparez votre venue avec votre classe ou vos parents en consultant sur Mediachimie.org l’espace métiers, les fiches métiers par fonction et domaine d’activité et la série de fiches « Les chimistes dans… ». Vous y découvrirez des dizaines de métiers de l’agent de laboratoire à l’ingénieur procédé, du biochimiste au commercial, du responsable du laboratoire d’analyse au chercheur, tout un panel de métiers est décrit.

Mediachimie sera aussi présent au village (stand M6) et une équipe de Mediachimie assurera deux conférences / ateliers : « La chimie, une grande diversité de métiers riches d’avenir » les vendredi et samedi à 14h.

Jean-Claude Bernier et Catherine Vialle

Février 2020

Plus d'informations : Village de la chimie des sciences de la nature et de la vie

#villagechimie

#gracealachimie

Préparez votre venue au Village de la chimie en testant vos connaissances sur les métiers (quiz)

Les marchés de Noël ont déménagé, les décorations et guirlandes de nos rues sur le point d’être démontées se balancent encore, et alors que sonne encore dans nos têtes le tube désenchanté de Gold « Ville de lumière, j’ai besoin de toi ! », peu savent la quantité de découvertes et de travaux qui ont conduit à de telles profusions de beauté visuelle (1).

Oublions les vieilles lampes à filaments aux verres colorés qui se balançaient entre les platanes des places des villages le soir du 14 juillet. La lampe à incandescence inventée par Thomas Edison avec filament de carbone en 1879 puis de tungstène au XXe siècle est maintenant bannie de la vente au profit des ampoules à basse consommation ou mieux encore des LED (Light Emetting Diode) qui ont envahi toutes les décorations lumineuses de Noël.

L’émission de lumière par des diodes semi-conductrices de SiC était connu depuis 1907 mais ce n’est qu’en 1929 qu’un brevet sur le principe d’émission fut déposé et il fallut plus de trente ans pour qu’une première LED donne une émission dans le rouge en 1962 (2).

Le principe des émissions par des semi-conducteurs électroluminescents est assez simple. Ils sont caractérisés par une bande de valence et une bande de conduction séparées par un « gap » d’énergie Eg. Lorsqu’un courant électrique active le semi-conducteur, un déséquilibre se crée entre les deux bandes et les électrons de la bande de conduction se combinent avec les trous créés dans la bande de valence en émettant un photon de fréquence ν tel que hν= Eg liée à la valeur du gap. Les chimistes du solide ont fait leur gamme en partant des semi-conducteurs de type III-V (3) pour obtenir du rouge avec GaAs et AlGaAs, du jaune avec GaAsP, du vert pour GaN. Ce n’est qu’en 1993 que des chercheurs japonais, prix Nobel en 2014 (4), ont obtenu la LED bleu avec la composition InGaN permettant grâce à une émission vers 480 nm de relancer la commercialisation des lecteurs sur support optique des DVD et de relever le défi économique de la lumière blanche pour le grand public. En effet plutôt que la recomposer avec trois LED bleu-rouge-vert on utilise maintenant l’émission d’une LED bleu encapsulée dans un dôme de silicone sur lequel on a une couche mince de luminophore émettant dans le jaune dont la composition est par exemple à base de YAG dopé au cérium (Y3Al5O12 : Ce3+). Les recherches actuelles tendent à diminuer la proportion d’émission bleue qui donne une lumière blanche trop froide pour une lumière plus chaude dans le jaune avec des luminophores (5) dopés à l’europium Eu2+ ou des oxysulfures avec des défauts structuraux pour limiter le recours aux lanthanides.

Les LED sont concurrencées par les OLED (Organic Light Emetting Diode) (6) qui sont constituées d’une couche mince de polymère semi-conducteur entre deux électrodes. Ces semi-conducteurs organiques sont caractérisés par l’alternance de simples liaisons et doubles liaisons carbones dites π-conjuguées. Les orbitales moléculaires ont alors deux niveaux, la plus basse est liante (HOMO), la plus haute antiliante (LUMO) qui s’assimilent aux deux bandes des semi-conducteurs métalliques avec les mêmes processus de recombinaison électrons-trous s’accompagnant d’émission de lumière. Si les OLED ont conquis les écrans plats des télévisions et des smartphones, elles ne sont pas encore concurrentielles pour les décorations lumineuses.

Mais la chimie est encore présente lors des nuits du nouvel an avec les incontournables feux d’artifices qui enflamment le ciel des métropoles (7). Leur principe est lié à la réaction chimique de combustion qui mêle un oxydant (nitrate, perchlorate) et un réducteur (carbone, soufre, magnésium) avec fort dégagement de chaleur et de gaz. Pour colorer les flammes on y ajoute des sels métalliques ; de strontium pour le rouge, sodium pour le jaune, baryum pour le vert, cuivre pour le bleu et poudres de magnésium ou aluminium pour le blanc éclatant. Notons que le tir et les explosions en altitude imposent que ce soient des professionnels qui sont en charge de ces feux et qu’il est toujours déconseillé que de simples amateurs s’y impliquent car leur sécurité est en jeu (8). C’est avec quelques regrets que janvier moins lumineux se déroule. Adieu la chimie des couleurs… À la fin de l’année 2020 !

Jean-Claude Bernier et Catherine Vialle

Janvier 2020

Pour en savoir plus :

(1) Lumière et couleurs (vidéo)

(2) EnLEDissez-vous !

(3) Les radars des avions Rafale (Chimie et… junior)

(4) Un prix Nobel éclairé

(5) Fluorescence (vidéo)

(6) Les diodes électroluminescentes organiques : des sources « plates » de lumière

(7) Les feux d’artifice des frères Proust (Petites histoires de la chimie)

(8) Une enquête explosive (Chimie et… junior)

Deux mois après l’incendie de l’usine Lubrizol nous avons un peu de recul pour revenir sur les risques des usines fabriquant ou stockant des produits chimiques (1). Depuis l’accident ayant frappé une ville du nord de l’Italie, Seveso, consécutive à une fuite de dioxine d’un site industriel voisin, l’Europe a imposé un haut niveau de prévention pour les sites présentant des risques majeurs. Le classement Seveso identifie pour l’environnement les risques suivants :- les effets de surpression (souffle d’une explosion) –les effets thermiques (rayonnement d’un incendie) – les effets toxiques (rejets de polluants) (2).

C’est ainsi qu’en France 1312 installations industrielles sont classées Seveso dont 607 seuil bas et 705 seuil haut dont Lubrizol de Petit-Quevilly. Après la catastrophe AZF à Toulouse qui fut bien plus meurtrière, la loi Bachelot en 2003 a institué en France les plans de prévention des risques technologiques (PPRT) qui visent à limiter l’urbanisation autour des sites dangereux. Comme hélas les municipalités jusque-là avaient laissé les constructions gagner les terrains proches, plus de 180 PPRT imposent des travaux de protection des habitations voisines.

Dans le cas de Lubrizol, soumis à une surveillance très stricte de la part de la DREAL Normandie comme ICPE (installation classée pour la protection de l’environnement), de nombreuses visites d’ingénieurs et de cadres pompiers vérifient la conformité et l’application des règles de sécurité (3). Et cependant fin septembre plusieurs milliers de tonnes de produits sont partis en fumée. Quels sont ces produits ? Dans la liste des 10 tonnages les plus importants on relève principalement des alcanes en C15 – C20, des graisses en C20 – C50 issus des distillats du pétrole, des additifs et des sels détergents pour l’essence comportant des dérivés d’amines, des sulfides ou des phosphates. Des lubrifiants (4) comportant des dithiophosphates, des oléfines et des produits insecticides avec des polysulfides. Par combustion ces produits vont émettre principalement CO, CO2 et H2O, mais aussi NO2, NOx et SO2, H2S, P2O5, ZnO et CaO. Mais comme les oxydations sont incomplètes également des suies principalement composées de carbone C qui vont composer ce nuage noir impressionnant de plusieurs kilomètres et se déposer aux alentours.

Les analyses de l’air sur Rouen menées par Atmo Normandie les 27 et 28 septembre sur NO2, SO2, CO, H2S et les PM10, ne montrent pas de valeurs supérieures aux moyennes habituelles dans l’agglomération (5). Des prélèvements sur le site de Lubrizol et les dosages sur le toluène, l’éthylbenzène, H2S et plusieurs COV (composés organiques volatils) donnent des valeurs en µg/m3 inférieures aux valeurs de référence d’exposition aigue sauf pour le benzène très largement au- dessus du seuil de 30µg. Raison pour laquelle il a fallu protéger la trentaine de personnel Lubrizol d’intervention et les pompiers. Depuis les prélèvements et analyses autour du site et sur le trajet du nuage faits par canisters, lingettes et jauges atmosphériques n’ont pas non plus donné des valeurs supérieures au seuil de dangerosité notamment sur les HAP (hydrocarbures aromatiques polycycliques), COV et dioxine. Les analyses sanguines opérées sur les sauveteurs n’ont rien décelé d’anormal une semaine après leur intervention.

Ces résultats n’empêchent pas une partie des Rouennais qui ont souffert de nausées (*), de problèmes respiratoires (6) et de nombreux maraîchers et agriculteurs qui ont perdu plus de deux semaines de ventes de légumes ou produits laitiers par mesure de précaution de s’élever contre la concentration industrielle de la banlieue ouest de Rouen.

Il n’est pas évident de rendre intelligible pour le grand public les résultats des analyses chimiques, surtout à l’heure où la parole des élus, des hauts fonctionnaires de l’État et des experts est systématiquement dévaluée et mise en cause. Même si les produits de Lubrizol sont indispensables dans de nombreux secteurs en particulier pour le fonctionnement des moteurs et les carburants automobiles où leur pénurie se fait déjà sentir, il n’est pas question pour l’instant d’imaginer une reprise possible d’activité sans que les règles ICPE (installation classée pour la protection de l'environnement) soient à nouveau respectées et que l’autorisation d’exercer soit donnée par le CODERST (conseil départemental de l'environnement et des risques sanitaires et technologiques) et le Préfet.

Communication difficile en ces circonstances, mais pour nous aussi chimistes, la communication est difficile et souvent insuffisante. Nous ne disons pas assez que l’industrie chimique (7) est indispensable à la fabrication d’objets de tous les jours, médicaments, shampoings, textiles, carburants, automobiles… Nous nous cachons dans l’ombre. Sur l’hexagone 3300 entreprises chimiques sont implantées avec 6000 sites de production dont 400 classés Seveso. C’est l’industrie qui est la plus réglementée. Depuis 2003, 500 millions € ont été investis pour la mise en place des PPRT, 300 millions pour la modernisation des installations et chaque année, 600 millions € (20% des investissements) sont consacrés à la sécurité et l’environnement.

Nous manquons de communicants et de communication pour rappeler que le secteur chimie est indispensable à l’économie avec 220000 salariés (8) qui contribuent au bien-être de nos concitoyens et à la balance commerciale avec plus de 60 milliards d’exportation.

(*) Sur le site il y avait une unité de fabrication de mercaptan à forte odeur écœurante. Le mercaptan est notamment utilisés à quelques ppm dans le gaz de ville pour détecter immédiatement une fuite.

Jean-Claude Bernier

Décembre 2019

Pour en savoir plus sur Mediachimie.org :

(1) Le paradoxe apparent de REACH : contrainte et source d’innovation pour la chimie

(2) La compétitivité plombée par un excès de règlementations ?

(3) Enquête technique après accidents industriels

(4) Les lubrifiants - « un point sur… »

(5) Techniques analytiques et chimie de l’environnement

(6) Pollution : comment améliorer la qualité de l’air dans nos habitations

(7) Pour une industrie chimique propre et durable (Chimie et… junior)

(8) Les chimistes dans : L’industrie chimique

Résultats d’analyses :

• Lubrizol: explications par Atmo Normandie

• Rouen : le point sur la situation sur le site gouvernement.fr. L’analyse des canisters est disponible ici à la date du 28 septembre 2019.

Près d’un Français sur quatre s’est vu répondre par son pharmacien « désolé, pour votre médicament nous sommes en rupture de stock » ou « désolé, votre médicament n’est plus fabriqué ». Rien qu’en France sur les traitements jugés essentiels on est passé de 44 signalements de pénuries en 2008 à 871 en 2018, près de vingt fois plus ! Quelles sont les raisons de cette évolution qui menace la santé publique (1) ?

Elles sont multiples. La première raison est la décomposition et la délocalisation de la chaine de fabrication des médicaments (2). Une part croissante de la production des principes actifs est délocalisée dans les pays où la main d’œuvre est moins coûteuse et les normes environnementales moins contraignantes, comme la Chine et l’Inde. Cette part est passée de 20% à 80% entre les années 90 et 2018. La deuxième étape, le mélange avec les excipients, est souvent faite en Amérique du Nord et enfin la présentation en gélules et l’emballage en Europe (3). Comme tout ce processus se fait en flux tendu par mesure d’économie, le moindre incident sur une chaine peut bloquer une usine sur plusieurs semaines . Par ailleurs, les agences du médicament nationales ou européennes, soucieuses de la protection des consommateurs, durcissent les normes de fabrication et de traçabilité des composants chimiques, ce qui amène parfois à ne plus importer tel générique de ces pays asiatiques dont la fabrication a été jugée trop opaque.

Bien que la pénurie frappe la France mais aussi la Belgique, le Royaume Uni, l’Italie, des experts pointent du doigt l’attitude de certains grossistes européens revendeurs de médicaments. Ils les accusent de faire passer en dernier la France où les prix des médicaments sont les plus bas, imposés par convention avec la sécurité sociale, et dont les remboursements sont sous surveillance à cause d’un budget qui souvent explose ! Par exemple les prix en France sont inférieurs de 20% à ceux pratiqués en Allemagne N’oublions pas non plus que les entreprises pharmacochimiques ne sont pas des bienfaitrices ; la concurrence internationale et la financiarisation de la profession exigent des investissements que les actionnaires souhaitent rémunérer. C’est ainsi qu’elles abandonnent progressivement la production de génériques trop bon marché et non rentables au profit de molécules nouvelles, susceptibles d’apporter des bénéfices, et de médicaments innovants parfois vendus à des prix exorbitants.

Alors, quels remèdes ? La relocalisation en Europe : c’est ce que font en France les 86 PME (petites et moyennes entreprises, entre 50 et 250 salariés) et ETI (établissements de taille intermédiaire, entre 250 et 5000 salariés) de la chimie, producteurs sous-traitants de principes actifs (4) en insistant sur l’aspect qualitatif et transparent des fabrications malgré un coût salarial et une exigence environnementale plus élevés. Ces entreprises bénéficient d’un très bon positionnement des compétences et d’un chiffre d’affaires en progression qui devrait encore s’améliorer en développant les médicaments issus des biotechnologies, médicaments qui manquent encore trop à leur catalogue (5).

Il n’y a pas que la santé qui souffre de causes de pénurie par manque de chimie. La guerre quasi idéologique que se livrent le Japon et la Corée du Sud pourrait avoir des répercussions en Europe. Le Japon a jeté l’embargo pour la Corée sur les résines photosensibles, les films minces de polyamide et… l’acide fluorhydrique. Ces composés représentent entre 60 et 80% des importations de deux géants de l’électronique Samsung et LG. Cela handicape fortement le gravage des micro-circuits (6) intégrés (résines de photogravure), le nettoyage des circuits silicium (HF) et la fabrication des Oled pour téléviseurs plans et smartphones (polyimides).C’est l’électronique grand public mondiale qui risque de tousser si d’autres approvisionnements ne sont pas trouvés. Or ni l’Europe ni la France ne sont capables à court terme d’y remédier. La chimie de base (fluor) et la chimie de spécialité (résines et polyimides) (7) n’y sont pas développées, en raison d’un marché intérieur insuffisant et des normes réglementaires.

Cela impacte également la transition écologique, actuellement très médiatisée, dont les objectifs sont menacés faute de chimie des matériaux. On oublie que l’objectif zéro carbone en 2030 ou 2050 sera très gourmand en matériaux de haute technologie. Pour les milliards de cellules photovoltaïque (8), on n’est pas inquiet pour le silicium abondant, mais plutôt pour le cuivre, le tungstène et l’argent. Les millions d’éoliennes et de véhicules électriques vont consommer des millions de tonnes d’aimants riches en néodyme et dysprosium (l’éolienne de General Electric de 12 MW annoncée pour 2021 comporte une tonne d’aimant au néodyme - aimant NdFeB). Les véhicules électriques seront aussi bourrés d’aimants et les batteries exigeront des millions de tonnes de Cu, Co, Ni et Li. L’Agence internationale de l’énergie estime qu’il faudra multiplier par 10 la production, la transformation et le recyclage de ces matières premières, avec toujours l’épée de Damoclès d’un éventuel quota chinois.

Militons pour l’implantation en France de la « Megafactory » l’Airbus des batteries et du complexe des aimants à base de terres rares, nous avons chez nous les meilleurs spécialistes mondiaux en électrochimie et magnétisme et le leader mondial de la séparation des terres rares. Re-industrialisons l’hexagone,, implantons de nouvelles usines chimiques propres, nous créerons de la valeur ajoutée nationale et de l’emploi et nous sauverons peut-être la planète.

Jean-Claude Bernier et Catherine Vialle

Octobre 2019

Pour en savoir plus sur Mediachimie.org :

(1) La chimie dans la vie quotidienne : au service de la santé (Chimie et… junior)

(2) Les chimistes dans l’industrie pharmaceutique

(3) De la conception du médicament à son développement : l’indispensable chimie

(4) La fabrication d’un principe actif (vidéo)

(5) Bioraffinerie et biologie de synthèse

(6) La chimie au cœur des (nano)transistors

(7) Les chimistes dans l’aventure des nouveaux matériaux

(8) Les panneaux solaires (animation)

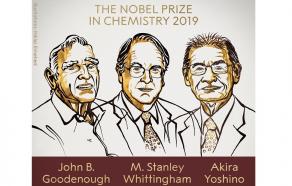

L’Académie suédoise vient de couronner les inventeurs des batteries ion-lithium (1). Voilà un prix Nobel de chimie qui va parler à tout le monde. Les utilisateurs de téléphones portables, de tablettes et d’ordinateurs, les conducteurs de véhicules hybrides et d’automobiles électriques se servent tous les jours de ces réservoirs de puissance électrique (2).

Ce sont trois chimistes qui ont permis il y a maintenant plus de trente ans la découverte, puis l’amélioration et enfin la commercialisation de ces batteries.

Stanley Whittingham, chercheur britannique, dirige l’institut des matériaux de l’université de Binghamton de l’État de New York. Il fut le premier à créer une cathode en sulfure de titane TiS2 dans une pile utilisant un sel de lithium, dans les années 1970.

John Goodenough, américain, est professeur de science des matériaux à l’université d’Austin au Texas. Il suggéra dans les années 1980 l’utilisation, à la cathode, d’oxydes mixtes de type LiCoO2 et ses dérivés Li(CONi)O2, Li(CoNiMn)O2. Il inventa également une nouvelle cathode Li FePO4.

Akira Yoshino, japonais, est professeur à l’université Meijo et membre de l’Asahi Kasei Corporation. Il est à l’origine de la commercialisation dans les années 1990 de ces batteries avec maintenant la forme cylindrique (D=1,8 H = 6,5cm) norme 18650, fabriquée à des milliards d’exemplaires.

Dans ces batteries, à la cathode, le lithium perd un électron qui passe dans le circuit extérieur et l’ion lithium Li+, issu de la cathode, rejoint l’anode en graphite à travers l’électrolyte. Avec la généralisation des objets portables et connectés, smartphones, tablettes, ordinateurs, outils, véhicules électriques, ce sont plus de 100 000 tonnes de lithium qui sont actuellement en usage dans les batteries ion-lithium. Les « mégafactories » construites ou en projet font craindre des cours élevés du carbonate de lithium et des métaux comme le cobalt ou le nickel (3). C’est dire l’incroyable succès de cette invention qui a mis vingt ans à se mettre au point avant commercialisation et moins de trente ans à devenir indispensable à notre quotidien.

Tous les chimistes du solide, les électrochimistes et spécialistes des matériaux se réjouissent de ce prix Nobel cher à leur discipline, spécialement en France où John Goodenough venait souvent discuter et faire des séminaires. Sa dernière venue en France, à 95 ans, lors de la journée hommage à Bordeaux le 26 mars 2018 à son grand ami le professeur Paul Hagenmuller, nous a permis de le rencontrer et de réécouter son rire légendaire et communicatif. Notons également que la communauté Française à Amiens, Bordeaux et Nantes est très active sur ce sujet et reconnue internationalement, sans oublier Michel Armand qui fut aussi l’un des novateurs sur ce sujet dans les années 1975.

Jean-Claude Bernier

Pour en savoir plus sur Mediachimie :

(1) Meilleurs matériaux pour batteries à ions Li. L’approche déductive et intuitive du chimiste (conférence vidéo)

(2) Le transport ou le stockage de l’énergie électrique (Chimie… et junior)

(3) Et si le cobalt manquait… quel serait l’avenir des véhicules électriques ?

Il y a pas mal de curiosités en chimie, les oxydes d’azote (1) en montrent une belle collection. Le monoxyde NO a une activité biologique importante et bénéfique pour notre corps, notamment dans la neurotransmission. Le dioxyde d’azote NO2 est beaucoup moins sympathique, il est caractérisé par des vapeurs rousses, irritantes et toxiques. Il se forme à haute température au-dessus de 1000°C par réaction entre l’azote et l’oxygène de l’air dans les brûleurs des centrales thermiques ou dans les moteurs à combustion interne (2). Le protoxyde d’azote N2O serait plus amusant car il est connu sous le nom de gaz hilarant. La description de la molécule N2O oscille entre 2 formes : N≡N+-O- et -N=N+=O.

Découvert par Joseph Priestley en 1772, les propriétés euphorisantes du protoxyde d’azote sont trouvées par Humphry Davy 25 ans après (3), mais c’est un dentiste Horace Wells qui découvre en 1844 qu’il peut être utilisé comme anesthésiant. Après quelques échecs en milieu médical, il fallut les études de William T. G. Morton en anesthésie pour que le protoxyde d’azote après le chloroforme soit utilisé en chirurgie après 1846. S’ensuivirent des progrès importants en médecine chirurgicale, la douleur et l’infection étant alors les deux grandes limites de la chirurgie.

C’est en réalité après 1960 puis 1980 que son usage médical s’est répandu et fut réglementé en associant le protoxyde d’azote à l’oxygène, ce qui élimine le risque d’asphyxie. La médecine utilise donc le MEOPA (mélange équimolaire d’oxygène et de protoxyde d’azote) depuis l’Autorisation de Mise sur le Marché (AMM) en 2001 dans les établissements hospitaliers. L’AFSSAPS (devenue depuis l’ANSM) contrôle et régularise depuis 2010 son utilisation dans les établissements de santé dans le cadre du plan national de la gestion des risques. Pourquoi ? Car comme le disait une publication dans la revue Science « N2O pas de quoi rire ! » (Nitrous oxide: no laughing matter). En effet même si dès le XIXe siècle le protoxyde était utilisé dans les foires pour mettre en joie quelques joyeux lurons, ses propriétés ne sont pas très bénéfiques.

D’abord dans l’atmosphère le protoxyde d’azote est un gaz à effet de serre plus de 250 fois plus absorbant que la même masse de CO2 (4), sa concentration a atteint 330 ppb (parties par milliard) en 2018. Plusieurs articles scientifiques le mettent aussi en cause comme agent destructeur de la couche d’ozone (5) en haute atmosphère. Les principales sources sont l’agriculture avec l’utilisation des engrais azotés et la décomposition du lisier ainsi que l’industrie et les transports, les rejets de ces derniers diminuant, surtout depuis que la dépollution des échappements automobile a fait des progrès (6).

Un nouveau danger qui guette les jeunes adolescents est une nouvelle forme de toxicomanie : le protoxyde d’azote est utilisé sous forme de drogue (7), inhalé pur dans un ballon de baudruche. Il procure un effet euphorisant qui dure environ 5 minutes sans laisser de traces. Cependant une utilisation répétée ou chronique provoque des troubles cardiaques ou neurologiques et des asphyxies ont été signalées. Très peu coûteux, il remplit les cartouches des siphons à chantilly qui sont en vente dans les supermarchés ou sur internet. L’inhalation directe à partir de ces cartouches sous pression peut également provoquer des brûlures et embolies pulmonaires. Un regain de cette mode est constaté depuis 2016/2018 chez les groupes d’étudiants ou d’adolescents. Certains élus, notamment des Hauts de France, souhaitent interdire la vente libre de ces cartouches ménagères.

Pour ma part je souhaiterais que le protoxyde d’azote ne soit pas accessible au grand public mais il pourrait être utilisé à la place du 2-chlorobenzylidène malonitrile (gaz CS) des grenades lacrymogène (8) des forces de l’ordre. Lors des manifestations on assisterait alors à une réconciliation euphorique entre CRS et manifestants au cours d’affrontements sans violences.

Jean-Claude Bernier

Septembre 2019

Pour en savoir plus

(1) Oxydes d'azote, Les produits du jour de la Société chimique de France

(2) La chimie atmosphérique : contexte, récents développements et applications

(3) La découverte des propriétés du gaz hilarant par Humphry Davy (1778 – 1829)

(4) Nom de code : CO2

(5) Chimie, atmosphère, santé et climat, une histoire partagée

(6) La catalyse au service de l'automobile

(7) Outils et techniques de profilage des drogues

(8) Il y a cent ans : la guerre chimique

C’est la période des grandes migrations. Paris et les grandes métropoles vont se vider et l’A7 et l’A10 vont nous montrer leurs périodiques bouchons. Vous allez profiter de la mer, de la montagne, de l’air non pollué et… du soleil. Comme il risque cette année de se montrer très généreux, faites attention à votre exposition et prenez un certain nombre de précautions. La chimie est là pour vous protéger.

Les rayons du soleil nous envoient une lumière avec un spectre de longueurs d’ondes très large allant de l’infrarouge aux ultraviolets (1). Ce sont ces derniers qui sont les plus dangereux pour la peau. Les UVC (100 à 280 nm) sont arrêtés dans la stratosphère par l’ozone (2) qui joue un rôle de barrière. Les UVB (280 à 315 nm) sont arrêtés par la peau au niveau de l’épiderme. Ils peuvent causer des coups de soleil et favorisent l’apparition de cancers de la peau, mais ils contribuent à la synthèse de la vitamine D. Les UVA (315 à 400 nm), les plus « durs », pénètrent jusqu’au derme et vont accélérer le vieillissement cutané. Ils peuvent provoquer des stress oxydants aigus (3) et entrainer mélanomes et cancers de la peau. 95% des UV qui traversent la couche d’ozone sont des UVA, le reste des UVB.

Pour vous protéger de ces UV on recommande d’appliquer généreusement les crèmes solaires (4) qui comportent des filtres solaires organiques ou minéraux. Plusieurs molécules telles les butyl méthoxydibenzoylméthane ou les bis-ethylhexyloxyphenol methoxyphenyl triazine absorbent en se transformant les UV. D’autres oxydes minéraux comme l’oxyde de titane (TiO2) (5) ou l’oxyde de zinc (ZnO) arrêtent et réfléchissent ces UV en laissant parfois des traces blanches sur la peau qui identifient leur protection.

N’hésitez donc pas à utiliser les crèmes solaires avant de vous exposer au soleil, que ce soit pour une séance farniente, du sport ou une balade. Consultez les indications figurant sur le tube ou le flacon. L’IP ou indice de protection, parfois noté SPF (Sun Protection Factor), va de 6 ou 10 pour une faible protection à 30 ou 50 pour une forte protection ou même 50+. Pour l’indice 10 cela signifie que c’est 1/10 du rayonnement UVB qui est transmis, pour l’indice 50 c’est 1/50 soit 2% des UVB qui atteignent la peau. Pour les UVA on admet que la protection est le tiers de celle des UVB.

Le problème est que la plupart des vacanciers au soleil ne connaissent pas leur taux d’exposition aux UV et donc le moment où il faut se protéger ou renouveler la protection.

C’est encore grâce à la chimie des encres polymères qui permettent de fabriquer des circuits électroniques imprimées (6) que le problème est maintenant en partie résolu. Après le patch « My UV » en 2016 qui, appliqué sur la peau, changeait de couleur en fonction de l’exposition et, après photo via une application sur smartphone (7), donnait le taux d’UV, L’Oréal a lancé l’an passé « UV Sense » un capteur d’UV connecté et sans batterie commercialisé cette année par La Roche-Posay. Ce dispositif de moins de 2 mm d’épaisseur et de 9 mm de diamètre se colle sur l’ongle du pouce. Il comporte un condensateur, des LED, un capteur et un circuit électronique imprimé (PCB – printed circuit board) flexible. Sensible aux UV il peut donner en temps réel l’évolution d’exposition et la garder en mémoire jusqu’à trois mois. Il suffit à l’utilisateur d’indiquer dans l’application disponible sur iOS et Android son phototype (blond aux yeux bleus et carnation claire ou noir aux yeux marron et peau mate) (8) pour recevoir et lire les recommandations personnalisées. Le design de la petite pastille a été particulièrement bien étudié et plait esthétiquement. Selon une étude auprès des consommateurs, plus de 35% d’entre eux appliquent plus souvent la crème solaire ou restent davantage à l’ombre. Si cette innovation permet de bloquer l’augmentation des cas de mélanomes, voilà une bonne contribution au bien-être estival.

Jean-Claude Bernier et Catherine Vialle

Août 2019

Pour en savoir plus

(1) Spectre et composition chimique du soleil (vidéo)

(2) Chimie atmosphérique et climat

(3) L’homéostasie redox de la peau et sa modulation par l’environnement

(4) Un exemple de composé chimique bénéfique à la santé de la peau : la crème solaire

(5) Les enjeux de la vectorisation et de la pénétration transcutanée pour les actifs cosmétiques

(6) La chimie des écrans souples (Chimie et… junior)

(7) Exploser un smartphone (Chimie et… junior)

(8) Les enjeux de la cosmétologie

Thomas Ebbesen, professeur à l’université de Strasbourg, vient de se voir décerner la médaille d’or 2019 du CNRS, l’une des plus prestigieuses récompenses scientifiques françaises. C’est au Japon lorsqu’il travaillait pour la société NEC en 1988 qu’il mène des recherches sur les nanomatériaux (1) à base carbone : d’abord les fullerènes (2), ces arrangements d’hexagones de carbone C60 ressemblant à de micro-ballons de football, puis il met au point les nouvelles synthèses des nanotubes de carbone (NTC) (3) et commence des travaux sur le graphène (4). Il met en particulier en évidence un état supraconducteur (5) à 33 K pour un C60 dopé au rubinium.

Ce n’est qu’après 1998 qu’il rejoint Strasbourg à l’Institut de science et d’ingénierie supramoléculaire (ISIS) dirigé alors par J.-M. Lehn. Il poursuit alors en France ses recherches commencées au Japon sur l’interaction lumière–matière (6) et « la transmission extraordinaire » ou comment faire passer de la lumière à travers une plaque métallique. « Physicien de l’impossible », il montre la possibilité de transmission de la lumière à travers de nano-trous du métal, dont la dimension est inférieure à la longueur d’onde du rayonnement. Cette découverte donnera lieu à deux publications fondatrices où il montre l’influence des plasmons de surface, ou capture d’une onde par une surface. Ces publications seront citées des milliers de fois.

Après 2012 Thomas Ebbesen se lance sur un « nouveau terrain de jeu », celui de la chimie polaritronique. S’inspirant des travaux théoriques de Serge Haroche et de Claude Cohen-Tanoudji sur les cavités quantiques, il arrive avec son équipe à changer les propriétés des molécules en les enfermant dans une cavité nanométrique entre deux plaques miroirs et en ajustant très précisément l’espace entre ces plaques dans un environnement électromagnétique - il faut réaliser que cet espace doit être de quelques nanomètres c’est-à-dire 1000 fois plus petit que l’épaisseur d’un cheveu. Il y alors échange mécanique de la molécule en résonance avec la cavité et échanges de photons virtuels. Sont alors créés ce qu’on appelle des états hybrides lumière–matière, dits états « polaritoniques ». Le plus surprenant est alors que l’on peut modifier ou exalter une réaction chimique dans ces conditions, des essais ont été réalisés avec des semi-conducteurs organiques, des enzymes, des systèmes biologiques. C’est une « chimie résonante ». Et plus qu’étonnante car Il y a cinq ans, les éditeurs scientifiques étaient incrédules et pensaient qu’il s’agissait de science-fiction. En 2019, avec les résultats qui s’accumulent, sa découverte suscite de nombreuses études théoriques et expérimentales.

Actuellement, Thomas Ebbesen, après avoir dirigé l’ISIS, est directeur de l’Institut d’études avancées de l’université de Strasbourg (USIAS). Il a déjà reçu de nombreux prix prestigieux dont en 2018 le Grand prix de la Fondation de la maison de la chimie pour ses recherches. Elles récompensent un chercheur imaginatif, aventureux, pluridisciplinaire et éminemment sympathique.

Jean-Claude Bernier et Catherine Vialle

Juillet 2019

Pour en savoir plus

(1) Colloque chimie, nanomatériaux, nanotechnologies 7 novembre 2018

(2) Les fullèrenes

(3) Nanotubes et nanofilaments de carbone

(4) Le graphénomène

(5) Les matériaux stratégiques pour l’énergie

(6) Emettre de la lumière grain à grain : échange quantique d’énergie (vidéo)

Image : © C. SCHRÖDER/UNISTRA

Alors que le 53e salon de l’aéronautique et de l’espace (1) vient d’avoir lieu au Bourget on peut rappeler que le premier salon en 1908 s’était tenu à Paris au Grand Palais sous l’égide de l’Automobile club. Ce rapprochement initial entre l’avion et l’auto semble à nouveau se réaliser en 2019. On voit en effet Airbus s’allier à Audi et Renault et expérimenter deux « taxis volants » City-Airbus et Vahana et par ailleurs plusieurs constructeurs de nouveaux hélicoptères se lancent dans l’exploitation de lignes taxi reliant le centre-ville aux aéroports des mégapoles.

Plusieurs raisons expliquent ces convergences :

- la croissance du trafic qui, selon l’IATA, devrait doubler d’ici 2040 et atteindre plus de 8 milliards de passagers avec une croissance annuelle de 4,5% nécessitant 37 000 avions pour Airbus et 42 000 pour Boeing. En conséquence, les procédés de fabrication et de montage des appareils devront mieux s’automatiser comme sur les chaines des constructeurs d’automobiles.

- une sécurité de plus en plus accrue, avec des commandes électriques nombreuses sûres et intelligentes. Cette évolution a été suivie par les équipementiers automobiles dont les véhicules électriques sont quasi prêts à la conduite autonome. Le développement du trafic va aussi conduire à une pénurie des pilotes dont les compagnies estiment le besoin entre 500 000 et 700 000 d’ici vingt ans. Sans évidemment passer par « zéro pilote dans l’avion », passer de 2 à 1 pour les moyen-courriers et de 5 à 2 pour les long-courriers avec des algorithmes de pilotages plus automatiques serait source d’économie financière et de formation.

Il est déjà vrai que le secteur aérien est devenu de plus en plus sûr grâce aux améliorations technologiques et à l’informatisation des commandes. Les risques et accidents ont été divisés par 8 ces 30 dernières années (avec cependant l’exception du Boeing 737 max) alors que le trafic a été multiplié par 4. L’apport de l’intelligence artificielle comme pour l’automobile devrait encore améliorer la sécurité.

Mais voilà que s’invite dans ce ciel bleu un nuage noir venu de Suède le « flygskam » ou « la honte de prendre l’avion » pour des raisons écologiques (2). En effet le prix à payer en équivalent CO2 du km passager en avion est largement prohibitif. L’exemple de Paris-Lyon, 2 heures en TGV 1,5 kg équivalent CO2, 5 heures en voiture et 80 kg équivalent CO2, 1 heure en avion et 97 kg équivalent CO2, montre une facture carbone élevée. C’est pourquoi un mouvement gagne la France, via la Scandinavie, les Pays-Bas et la Belgique, où certains citoyens souhaitent ne plus prendre l’avion pour des vols intérieurs européens et préférer le train. L’objection contraire la plus souvent observée est la durée du voyage et son prix. L’exemple du Paris Londres en avion 1h05 et 58€ ou par le Thalys en 2h28 et 157 € est démonstratif. Il faudrait donc que les sociétés de chemin de fer et les États fassent baisser le prix du rail et taxent les airs pour encourager ces comportements.

D’autres solutions sont possibles (3). Déjà un logiciel utilisé par deux compagnies permet d’optimiser les trajets pour les long-courriers et les approches des aéroports, entrainant une économie de 20 à 30% de kérosène. De nouveaux moteurs, tels ceux de Safran équipant les nouveaux appareils, sont robustes et économes (4). L’allègement des structures en passant des métaux aux matériaux composites a drastiquement diminué les consommations (5). On se rappelle « Solar impulse » et ses multiples innovations en chimie : cet avion a fait le tour du monde grâce à l’électricité (6), sans une goutte de carburant, et a ouvert le champ de recherche de la propulsion électrique (7). Même si actuellement on bute encore sur le verrou technologique du ratio énergie stockée / poids des batteries, on devrait à l’avenir rendre possible au moins les appareils hybrides pouvant parcourir une partie du trajet avec des hélices mues par des moteurs électriques à coté de moteurs thermiques classiques. À l’heure actuelle les packs de batteries ion-lithium (8) permettent déjà sur le tarmac des roulages et manœuvres au sol économes et plus silencieuses. Il reste enfin la possibilité d’utiliser grâce à la chimie du kérosène issu de la biomasse, soit des algocarburants issus des microalgues (9) soit des biokérosènes venant des huiles végétales par le procédé Vegan (HVO - Hydrotreated Vegetable Oil) mis au point par l’IFPEN et utilisé par TOTAL à la raffinerie de la Mède (10).

Je ne sais pas si vous vous priverez de vacances au soleil au Maroc aux Baléares ou pire à la Réunion pour ne pas augmenter votre empreinte carbone. Pour que vous n’ayez pas trop de honte à prendre l’avion on peut rappeler que les milliers de participants à la COP 24 à Katowice en décembre 2018 ont généré 55 000 tonnes de CO2, soit l’équivalent de l’empreinte carbone de 4600 Français en un an !

Jean-Claude Bernier

Juin 2019

Pour en savoir plus

(1) Colloque la chimie, l'aéronautique et l'espace

(2) Atmosphère ! Atmosphère ! Alerte !

(3) Demain, l’aviation plus verte et plus autonome

(4) Les défis matériaux et procédés pour les équipements aéronautiques

(5) Les nouveaux matériaux composites pour l’aéronautique

(6) Solar impulse 2 et la chimie

(7) Sur les ailes de l’avion solaire (vidéo)

(8) Le transport ou le stockage de l’énergie électrique

(9) Zoom sur la valorisation des algues

(10) Polémiques dans le monde des biocarburants

Image : Wikimedia / Julian Herzog. Licence CC-BY 4.0